Produktivitätssteigerung ist das Mantra des Cloud Computing. Das zeigen die Überschriften von aktuellen Fachveröffentlichungen. Als kleine Auswahl: Wie Cloud Computing die Produktivität ihres Recruiting steigert. Produktivität steigern durch Automatisierung. Wie der Digital Workplace produktiver macht. Die Cloud als zentraler Produktivitätsfaktor. Usw. usf.

Doch wo genau erzeugt die Cloud eine höhere Produktivität? Diese Frage ist nicht ohne weiteres zu beantworten. Zumindest aus der Sicht der Gesamtwirtschaft wächst die Arbeitsproduktivität seit Jahrzehnten kaum noch. Eine erklärungsbedürftige Entwicklung, denn genau in diesen Zeitraum fällt die flächendeckende Verbreitung von Informationstechnologie. Trotz ihres großen Produktivitätsversprechens scheint es, als seien Unternehmen kaum produktiver geworden.

Dieser Zusammenhang wird auch als das Produktivitätsparadoxon der Informationstechnologie bezeichnet. Es gibt eine Menge Hinweise darauf, dass die Hypothese stimmt. Ein alltägliches Beispiel: Office-Software verlagert die Arbeit am Inhalt auf Gefrickel an der Form. Dadurch wird ein simpler Bericht zum Zwischenstand eines Projekts zu einem Hochglanzdokument in Magazin-Optik. Kostete ein solcher Bericht in den frühen achtziger Jahren vielleicht 500 Mark an Material und Arbeitseinsatz, so geht es heute in den vierstelligen Bereich – da ist sie hin, die Arbeitsproduktivität.

Einfach Cloud? Nein, hybride Multi-Cloud

Um die Frage nach der Produktivität der Cloud wenigstens einigermaßen beantworten zu können, zunächst ein Blick auf eine wichtige Stoßrichtung von Cloud Computing: Der Ersatz selbstbetriebener IT durch eine neue Form von Outsourcing. Am deutlichsten ist dies bei Geschäftsanwendungen, die im Browser genutzt werden. Software as a Service (SaaS) ersetzt lokal installierte Programme.

Zunächst einmal ist das eine Win-Win-Situation. Der Hersteller der Software erspart sich den Aufwand für die Distribution. Es gibt nur noch ein Release, dessen einzige Instanz gepflegt und weiterentwickelt wird. Updates stehen allen Nutzern sofort zur Verfügung. Admins in Unternehmen müssen keine Software verteilen, kein Patchmanagement betreiben und nur vergleichsweise wenige Computerressourcen bereithalten.

Doch der Rückschlag folgt auf dem Fuße. Durch die Möglichkeit der schnellen Releases hat sich eine Featuritis breitgemacht, sowohl bei einzelnen Cloudservices als auch im Gesamtmarkt. Inzwischen gibt es für jedes nur denkbare Problem irgendeine Cloudanwendung. Kanban-Boards online? Kein Problem mit Trello. SEO-Texte unkompliziert verfassen? Searchmetrics steht bereit. Sprachaufzeichnungen transkribieren? Hier lang zu Trint.

Und das ist nur SaaS. Wer sein Rechenzentrum abschaffen möchte, kann Cloudinfrastruktur bei fünf großen und Dutzenden kleineren Anbietern buchen. Der Funktionsumfang der Marktführer ist gigantisch, ihre Leistungsfähigkeit ebenso und viele ihrer Spezialfunktionen sind konkurrenzlos. So nutzen Unternehmen häufig zahlreiche SaasS-Anbieter und Infrastrukturservices zur gleichen Zeit – die viel zitierte Multi-Cloud ist entstanden.

Sie ist außerdem oft eine Mischung aus lokalen und wolkigen Anwendungen – die Hybrid-Cloud. Der Grund: Zumindest in den KRITIS-Branchen dürfen viele Cloudanwendungen nur in einer Private Cloud im eigenen Rechenzentrum betrieben werden. Die EU-Datenschutzregeln fügen dem weitere strenge Anforderungen hinzu, sodass viele internationale Clouds ungeeignet sind. Was aber ihre Nutzung nicht verhindert, wenn es um nicht datenschutzrelevante Informationen geht.

Die Cloud: Nicht weniger komplex als früher, nur anders

Die Unternehmen befinden sich also in einem Dilemma: Auf der einen Seite machen Cloudservices tatsächlich vieles einfacher. Auf der anderen erhöhen sie die Komplexität der IT auf neue Weise, etwa durch eine aufwändige Konfiguration und Integration der Cloudservices. Bereits ein scheinbar simpler Service wie Microsoft Office 365 Enterprise erweist sich beim näheren Hinschauen als Labyrinth, das ebenso kenntnis- wie trickreiche Admins erfordert.

Eine Explosion der Komplexität ist zudem die Folge, wenn zusätzlich zur Public Cloud auch selbstbetriebene Anwendungen wie die SAP-Suite und eine Private Cloud zu einem stabilen und leistungsfähigen Ganzen integriert werden sollen. Hier endet dann das Versprechen der Cloud, IT ganz einfach zu machen. Denn ohne Know-how und Erfahrung geht nichts. Die beim Auflösen des eigenen IT-Betriebs freigesetzten Admins sind zur Vordertür hinaus und zur Hintertür wieder hereingekommen. In vielen großen Unternehmen ist sogar das Gegenteil einer Vereinfachung passiert: Die Kosten für Investitionen und Personal in der IT steigen seit Jahren.

Zudem wächst auch der Beratungsbedarf. Ein Beispiel ist die Highend-Cloudanwendung Salesforce. Sie ist an ihrer Basis immer noch eine einfach zu nutzende CRM-Lösung, bietet aber zudem viele neue Möglichkeiten rund um Kundenservice, Social Media und interne Zusammenarbeit. Wenn ein Unternehmen diesen Mehrwert nutzen will, muss es zuerst auf den Prüfstand. So setzen viele Möglichkeiten von Salesforce auch entsprechende Strukturen voraus. Wer zum Beispiel die inhaltliche Expertise nicht im Haus hat, kann mit den entsprechenden Funktionen nur wenig anfangen.

Beratungsbedarf: Cloudservices in Etappen einführen

Im zweiten Schritt muss der Nutzer Salesforce an die bestehende digitale Infrastruktur anpassen, meint Florian Gehring, Gründer des Consulting-Unternehmens Salesfive, das sich auf Beratung von Salesforce-Nutzern spezialisiert hat. Ein boomender Sektor: Seit der Gründung 2016 ist das junge Unternehmen auf knapp 70 Mitarbeiter angewachsen und hat weit über 250 erfolgreiche Beratungsprojekte verwirklicht. Der Kundenstamm reicht dabei von Startups über Hidden Champions aus dem Mittelstand bis hin zu Konzernen.

„Salesforce ist gut darin, die Komplexität der Cloud von den Anwendern abzuschirmen“, sagt Gehring. „Man muss kein Entwickler oder Informatiker sein, um Salesforce richtig aufzusetzen. Die Setup-Konsole funktioniert wie ein Baukastensystem und führt die Nutzer zuverlässig zum Ziel.“ Das sei auch das Prinzip von Salesforce, die Anwender sollten möglichst viel selbst machen. Der Salesfive-Gründer betont: Die eigentliche Komplexität entstehe auf einem anderen Feld.

„Salesforce hat ein offenes Ökosystem aufgebaut, in das die Nutzer sehr viele verschiedene andere Systeme integrieren können“, erklärt Sven Strehlke, Mitgründer von Salesfive. „Dazu muss aber ein Digitalisierungskonzept definiert werden. Hier liegt unsere eigentliche Beratungsleistung.“ Seiner Meinung nach holen im Moment noch nicht alle Nutzer das Maximum aus Salesforce heraus. Das könne sein, weil sie die Komplexität der Möglichkeiten nicht überblicken oder weil sie Unterstützung bei der Integration von Drittsystemen benötigen.

In der Praxis arbeiten die Berater von Salesfive vorwiegend in Multi-Cloud-Projekten, bei denen Komplexität selbstverständlich ist. Hinzu kommt, dass Salesforce neben CRM auch Service, Marketing, Commerce, verschiedene Industrielösungen und vieles mehr anbietet – und auch immer mehr Kunden darauf zugreifen. Dahinter verbergen sich große Change-Projekte: „Es ist wichtig, ein iteratives und agiles Verfahren zu wählen, bei dem die Stakeholder eingebunden werden.“ sagt Strehlke. „Es gibt einen enormen Beratungsbedarf, vor allem im Mittelstand. Dort arbeiten sehr viele Unternehmen noch mit einer Kombination aus Notizblock und Excel.“

Cloudproduktivität lässt sich nur schwer messen

Dieser Ausflug in das Salesforce-Ökosystem zeigt, dass die Zeiten einfacher Lösungen vorbei sind. Wenn ein Unternehmen von der Cloud profitieren will, muss es zu 100 Prozent auf sie setzen. Umfassende Digitalisierung ist gefragt. Wer noch Papierschnittstellen und Excel-Basteleien nutzt, verschenkt viel Potenzial.

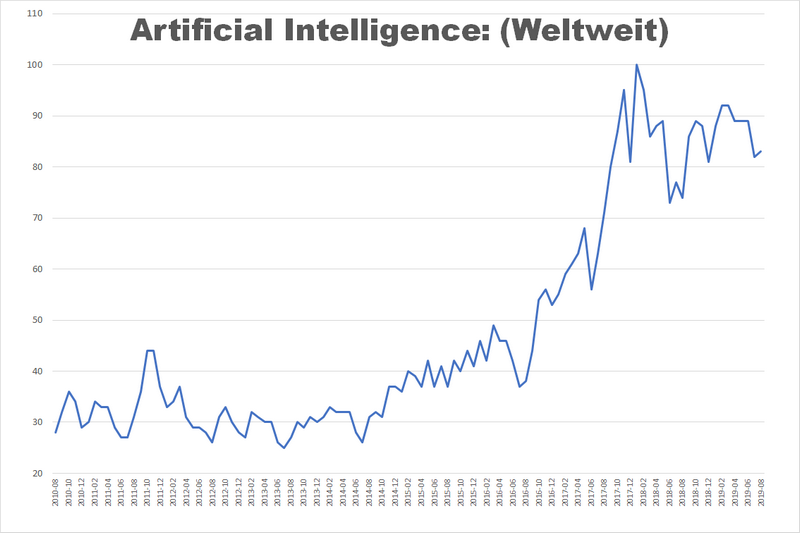

Und was ist mit der Produktivität? Vermutlich ist das Produktivitätsparadoxon nur ein Trugbild. Es basiert auf einer Vorstellung von Produktivität, die auf Messungen zurückgeht. Alles, was sich nicht (ohne weiteres) messen lässt, fällt demnach nicht unter die Produktivität. Denn der eigentliche Vorteil der Entwicklung des Cloud Computing in den letzten 15 Jahren liegt nicht in einer Produktivitätssteigerung, die an simplen KPIs ablesbar ist. Sie liegt in den neuen Möglichkeiten, die uns ohne Cloud nicht verfügbar wären.

Ein Beispiel: Vor 25 Jahren wurden im Marketing in erster Linie Broschüren per Post versendet. Damals gab es noch keine Nahe-Echtzeit-Kommunikation via Facebook oder LinkedIn. Sie ist chancenreich, aber auch kostenträchtig – vor allem beim Personal. Die Idealvorstellung ist ein Newsroom mit 24×7-Besetzung, der im Notfall zu jeder Tages- und Nachtzeit aggressiv aufgeschaukelte Diskussionen glättet.

So machen heute oft zwei Dutzend Leute eine Aufgabe, die es vor einem Vierteljahrhundert gar nicht gab. Aus einer stark vereinfachten Sicht heraus macht das Marketing heute nichts anderes als früher™, aber mit dem zigfachen Personal und entsprechend höheren Gestehungskosten. Die entscheidende Frage bei der Produktivität der Cloud: Welche Aufgaben ermöglicht sie. Es geht nicht darum, einen fixen Bestand an Arbeit auf weniger Köpfe zu verteilen. Es geht darum, in einem durch Digitalisierung und Informationstechnologie bestimmten Alltag zu arbeiten.

Bildquelle: Pixabay